Por. Eduardo Levy Yeyati

Un tren corre sin frenos. Más adelante hay dos personas atadas a las vías. El tren pasa bajo un puente. En el puente hay una palanca que hace que el tren cambie de vía hacia otra en la que, más adelante, hay una persona atada a la vía. Usted está en el puente, la mano sobre la palanca. Dos por uno. ¿Qué hace?

Ahora hagamos un pequeño cambio: en el puente en vez de una palanca hay un hombre pesado y la única manera de frenar el tren y evitar la muerte de las dos personas es empujar al extraño a las vías. Dos por uno. ¿Qué hace?

La visión utilitaria es clara: vale matar a uno para salvar a dos. Sin embargo, desde el punto de vista moral, el problema no tiene una respuesta única. En el primer caso, la mayoría de las personas (pero no todas) elige accionar la palanca; en el segundo, la mayoría (pero no todos) se niega a empujar al hombre pesado. Y si, en el segundo caso, la pregunta se hace en un idioma extranjero, más personas eligen empujar el hombre: el lenguaje genera un distanciamiento entre fin y medios comparable a la intermediación de la palanca. ¡Y eso que aún no pusimos a nuestro sujeto a decidir arriba del puente y con personas de carne y hueso!

Ahora pasemos al robot o, para darle un aire más inminente, al coche autodirigido. Una persona cruza la calle en rojo y con la vista en su smartphone. Si el coche la esquiva y sube a la vereda, embiste a dos personas que dialogan café de por medio en la vereda de un barcito. Usted es el programador del coche. ¿Qué decisión moral programa en el código?

La primera de las tres leyes de la robótica de Isaac Asimov dice: Un robot no hará daño a un ser humano o, por inacción, permitirá que un ser humano sufra daño.

Si quisiéramos independizar totalmente al coche autodirigido -es decir, si quisiéramos hacerlo verdaderamente auto dirigido-, deberíamos programarlo como un utilitarista, modificando la primera ley de la robótica a algo así como: «Un robot no hará daño a un ser humano salvo que, por inacción, genere daños mayores a otros seres humanos.»

(Es cierto que podríamos poner a un ser humano supervisor que decidiera por el robot. Después de todo, si algo enseña el problema del tren es que para un ser humano es más sencillo dar la orden que ejecutarla. El supervisor miraría a un lado y ordenaría resignado a su coche: «Salva la mayor cantidad de vidas» -aunque al dar la orden al robot, éste entraría en conflicto con la segunda ley de la robótica de Asimov: Un robot debe obedecer las órdenes dadas por los seres humanos, excepto si estas órdenes entrasen en conflicto con la primera ley.)

Dos muertes son estrictamente mayores que una muerte: sacrifico a la persona del smartphone para salvar a dos personas en la vereda. Pero ¿qué pasa si el que cruza es un niño y los libadores de café son dos ancianos? ¿Cómo comparar vidas humanas? Peor aún: la muerte, que es absoluta, no es el único desenlace posible: ¿Cómo comparar daños si la colisión no es fatal?

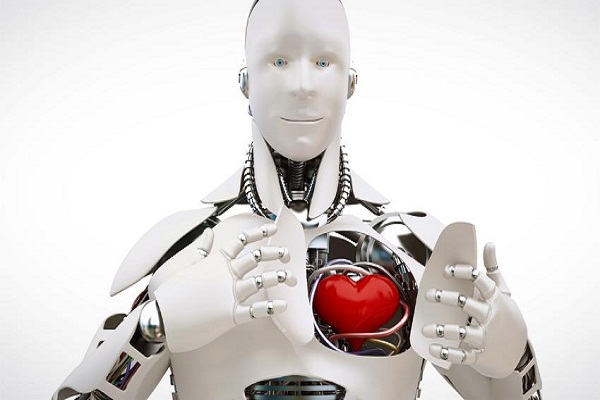

El código se complica. La moral del robot es inhumana.

El robot reemplaza primero tareas rutinarias; luego, por imitación, tareas más complejas. Pero hay un umbral infranqueable, esencialmente humano, cuando nos aproximamos a las decisiones morales para las que, por definición, el humano no tiene una respuesta cierta e inmutable.

Tal vez allí esté el mayor escollo para la digitalización total, el resquicio último por el que se cuela el protagonismo del ser humano. Nuestra última trinchera.

La intervención humana, que es absoluta, no es el único desenlace posible: tal vez algún día resignemos nuestro pequeño resquicio de humanidad y dejemos las decisiones morales en manos de un robot utilitario y racional.

Fuente: http://www.lanacion.com.ar/1940800-la-moral-del-robot

Imagen: www.khaleejtimes.com/storyimage/KT/20160102/ARTICLE/160109960/AR/0/AR-160109960.jpg&MaxW=780&imageVersion=16by9&NCS_modified=20160102113146

Users Today : 40

Users Today : 40 Total Users : 35403013

Total Users : 35403013 Views Today : 49

Views Today : 49 Total views : 3332222

Total views : 3332222