Por: Hayah García || Junio 2023 || Twitter: @hayah_garcia

En los últimos años, los desarrollos informáticos han dado un salto épico y superaron a los llamados supercomputadores que serán remplazados por equipos cuánticos pues permitirán resolver problemas complejos de manera más eficiente que las computadoras tradicionales basadas en la electrónica de estado sólido. En este artículo, se explora el funcionamiento de los computadores cuánticos, su arquitectura de procesadores, los usos que se les han dado, sus fabricantes y en qué países se encuentran. También se destaca la relación entre la computación cuántica y la inteligencia artificial, así como la diferencia entre QuBits y los Quarks.

Funcionamiento del Computador Cuántico

El funcionamiento de un computador cuántico se basa en la superposición y la entrelazación cuántica. Mientras que en una computadora clásica un bit puede existir en solo un estado sea un 0 o 1, en un computador cuántico, un qubit puede estar en una superposición de ambos estados de forma simultánea. Esto se debe a las propiedades de la mecánica cuántica, donde estas unidades pueden representar múltiples estados en un mismo momento.

La superposición es una propiedad fundamental de los sistemas cuánticos en la que un qubit puede estar en múltiples estados al mismo tiempo. Mientras que un bit clásico solo puede estar en un estado 0 o 1, un qubit puede representar una combinación lineal de ambos estados simultáneamente. Esta propiedad permite realizar cálculos en paralelo y explorar múltiples soluciones de manera eficiente.

A esto se une el entrelazamiento es una propiedad en la que dos o más qubits están correlacionados de manera intrincada, incluso cuando están separados en el espacio. Esto significa que el estado de un qubit está directamente relacionado con el estado de los demás qubits entrelazados, sin importar la distancia física entre ellos. El entrelazamiento es crucial para la comunicación y la transferencia de información en sistemas cuánticos.

Estas propiedades cuánticas, la superposición y el entrelazamiento, son la que les permiten a los computadores cuánticos realizar cálculos de manera simultánea y explorar múltiples soluciones en paralelo. En problemas complejos, esta capacidad cuántica puede llevar a un rendimiento exponencialmente mayor en comparación con los computadores clásicos, especialmente en aplicaciones específicas, como la búsqueda en bases de datos no ordenadas o la factorización de números grandes utilizados en la criptografía.

Sin embargo, es importante tener en cuenta que no todos los problemas se benefician de la computación cuántica, y existen desafíos significativos en el desarrollo de sistemas cuánticos estables y libres de errores. Además, la capacidad de los computadores cuánticos para superar a los computadores clásicos depende de la naturaleza específica del problema y del algoritmo utilizado.

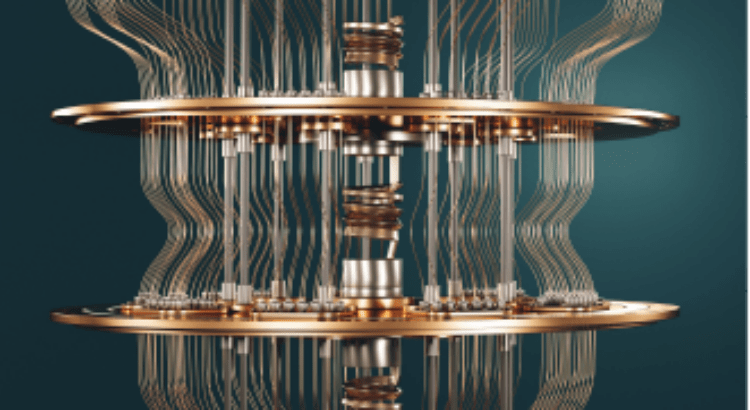

Arquitectura de los Procesadores Cuánticos

La arquitectura de los procesadores cuánticos varía según la implementación. Algunos enfoques utilizan átomos o partículas subatómicas individuales como qubits, mientras que otros utilizan circuitos superconductores o puntos cuánticos. No se basan en transistores clásicos como los de los procesadores tradicionales, sino en componentes que operan a temperaturas extremadamente bajas para evitar la decoherencia, un fenómeno que perturba la información cuántica.

Usos de los Computadores Cuánticos

Los computadores cuánticos tienen el potencial de revolucionar numerosas áreas de la ciencia y la tecnología. Actualmente, se están investigando aplicaciones en criptografía, simulaciones moleculares, optimización, inteligencia artificial y descubrimiento de nuevos medicamentos. La capacidad de los computadores cuánticos para procesar grandes cantidades de información de manera simultánea podría impulsar avances significativos en campos que requieren cálculos muy complejos.

Elementos de la Mecánica Cuántica y el computador moderno

La mecánica cuántica, como teoría fundamental de la física, proporciona las bases teóricas y las propiedades fundamentales que han permitido el desarrollo de la computación cuántica. Otras de las propiedades clave de la mecánica cuántica que son relevantes para la computación cuántica son:

Principio de incertidumbre de Heisenberg: establece que existe una limitación fundamental en la precisión con la que se pueden conocer ciertas propiedades de una partícula cuántica, como su posición y momento lineal. Este principio tiene implicaciones en la medición y el procesamiento de información cuántica, ya que no se puede conocer con certeza el estado cuántico completo de un sistema sin alterarlo.

La interferencia cuántica: es un fenómeno en el que los resultados de un cálculo cuántico dependen de la interferencia constructiva o destructiva de las amplitudes de probabilidad asociadas con diferentes posibles estados cuánticos. Esto permite la manipulación y la optimización de las probabilidades de obtener ciertos resultados y es esencial para los algoritmos cuánticos, como el algoritmo de Grover y el algoritmo de Shor.

Estas propiedades de la mecánica cuántica han permitido el desarrollo de la computación cuántica al proporcionar una base teórica para la manipulación de información cuántica y realizar cálculos de manera diferente a la computación clásica.

Relación entre el Quarks y el Qubits?

Los quarks son partículas elementales que se consideran componentes fundamentales de la materia. Según el modelo estándar de la física de partículas, los quarks son partículas elementales, lo que significa que no se cree que estén compuestos por partículas más pequeñas. Estas que llevan una fracción de la carga eléctrica y se unen a través de la interacción fuerte para formar partículas compuestas llamadas hadrones. Los hadrones más familiares son los protones y los neutrones, que se encuentran en los núcleos de los átomos. Los protones están compuestos por dos quarks arriba (up) y un quark abajo (down), mientras que los neutrones están compuestos por un quark arriba y dos quarks abajo.

Es importante destacar que los quarks son partículas que se rigen por los principios de la mecánica cuántica, lo que significa que también exhiben fenómenos cuánticos, como la superposición y el entrelazamiento cuántico. Sin embargo, en el contexto de la computación cuántica, los quarks no están directamente relacionados aunque los términos «qubits» y «quarks» suenan similares.

En resumen, los quarks son partículas cuánticas elementales que se unen para formar hadrones, como los protones y los neutrones. Aunque comparten la base cuántica, los quarks y los qubits son conceptos distintos en diferentes ámbitos de estudio: la física de partículas y la computación cuántica, respectivamente.

Algunos Computadores Cuánticos

A continuación muestro una lista de los últimos desarrollos de computadoras cuánticos centrados en los Estados Unidos y Canadá, así como su potencia:

- D-Wave One (2007) ||Fabricante: D-Wave Systems || Ubicación: Canadá || Potencia (Qubits): 128 qubits

- IBM Q Experience (2016) || Fabricante: IBM || Ubicación: Estados Unidos || Potencia (Qubits): Varía según el dispositivo; hasta 65 qubits en 2021

- Rigetti Quantum Computer (2017) || Fabricante: Rigetti Computing || Ubicación: Estados Unidos || Potencia (Qubits): Hasta 32 qubits en 2021

- Google Quantum Computer (Sycamore) (2019) || Fabricante: Google (en colaboración con diversas instituciones académicas) || Ubicación: Estados Unidos || Potencia (Qubits): 54 qubits

- IonQ Quantum Computer (2020) || Fabricante: IonQ || Ubicación: Estados Unidos || Potencia (Qubits): Hasta 32 qubits en 2021

Es importante tener en cuenta que estas son solo algunas de las compañías y sistemas de computación cuántica existentes hasta septiembre de 2021. La tecnología de computación cuántica está en constante evolución, y se espera que nuevos desarrollos e innovaciones se produzcan con el tiempo.

Y los Computadores Cuánticos de los países BRICS y Europa?

En Rusia, el Centro Nacional de Investigación en Tecnología Cuántica (CRTQ) está trabajando en el desarrollo de computadores cuánticos. Han anunciado planes para construir un computador cuántico con una arquitectura basada en trampas de iones y se espera que alcance alrededor de 100 qubits.

El gigante asiático, ha realizado avances significativos en la investigación y desarrollo de computadores cuánticos. La Academia China de Ciencias ha estado trabajando en proyectos de computación cuántica y ha logrado construir un computador cuántico con 66 qubits. Además, el gobierno chino ha establecido el Centro Nacional de Ciencia Cuántica en China para impulsar aún más la investigación y el desarrollo en este campo.

Origin Quantum (China) ya avisó que estaban creando un nuevo tipo de ordenador cuántico. Hubo mucho misterio alrededor de este y de lo poco que se sabía es que buscan lograr una versión para uso doméstico, logrando desarrollar el Wuyuan de Origin Quantum, el primer ordenador cuántico comercial de China con una potencia de 24 qubits.

En India, el Instituto Indio de Tecnología y el Instituto de Ciencias Matemáticas está involucrado en la investigación y el desarrollo de computadores cuánticos. Se están llevando a cabo proyectos y colaboraciones para construir sistemas cuánticos y se están explorando diferentes enfoques, como la computación cuántica basada en luz y la computación cuántica superconductora.

Así también en Europa, varios países y organizaciones están trabajando en el desarrollo de computadores cuánticos. La Unión Europea ha invertido en el proyecto Quantum Flagship, que tiene como objetivo acelerar la investigación y el desarrollo en tecnologías cuánticas, incluida la computación cuántica. Además, varios países europeos, como Alemania, Francia, los Países Bajos y el Reino Unido, tienen sus propios programas de investigación y desarrollo en computación cuántica. A esta carrera se suma España quienes ya están realizando inversiones y enlaces con IBM para desarrollar tecnología cuántica en un esfuerzo mancomunado con la Unión Europea.

Es de señalar que en cuanto a la potencia de los computadores cuánticos específicos en estos países, la información puede ser limitada y variada debido a la naturaleza de la competencia en la investigación y desarrollo de computadores cuánticos. Además, la potencia de un computador cuántico no se mide solo en términos de la cantidad de qubits, sino también en otros factores como la estabilidad y la capacidad de corrección de errores. Por lo tanto, no puedo proporcionar información específica sobre la potencia exacta de los computadores cuánticos en estos países.

Qué empresas lideran la computación cuántica?

Hasta ahora IBM es quien lidera el mercado de desarrollo de computadores, sin embargo otros gigantes del software y la electrónica como Microsoft (creo una interfaz gráfica para dar órdenes al computador cuántico llamado LIQUi|>), Amazon (brinda a sus usuarios experiencia práctica con qubits y circuitos cuánticos para ser simulados en computadores cuánticos reales), Alibaba (BABA), Tencent (TCEHY), Nokia (NOK), Airbus, HP (HPQ), AT&T (T) Toshiba, Mitsubishi, SK Telecom, Thor, Lockheed Martin, y empresas como Righetti, Biogen, Volkswagen y Amgen están investigando y desarrollando diversos programas para las computadoras cuánticas, para su uso particular como comercial.

Computación Cuántica e Inteligencia Artificial

La relación entre la computación cuántica y la inteligencia artificial es prometedora. Los computadores cuánticos podrían acelerar el procesamiento de algoritmos de aprendizaje automático y optimización, lo que podría conducir a avances significativos en la inteligencia artificial regenerativa. Algunos algoritmos de IA, como el algoritmo de Grover y el algoritmo de búsqueda cuántica, aprovechan las propiedades cuánticas para mejorar la eficiencia y la velocidad de cálculo en comparación con los métodos clásicos al permitir realizar cálculos en paralelo y explorar múltiples soluciones simultáneamente, lo que podría conducir a mejoras en el reconocimiento de patrones, la toma de decisiones y la generación de modelos predictivos más precisos.

Próximos desarrollos de microprocesadores cuánticos

Al momento de escribir este artículo IBM ya le había puesto fecha a los desarrollos de sus procesadores cuánticos presentando a finales noviembre de 2002 Osprey con 433 qubits, para finales de 2023 presentaría Condor un chip cuántico de 1.121 cúbits. Ya para 2024 llegaría Flamingo con al menos 1.386 qubits; y en 2025 Kookaburra, con no menos de 4.158 qubits.

Intel por su parte se une a la carrera y acaba de lanzar su primer procesador cuántico bautizado como Tunnel Falls, el cual se caracteriza por estar basado en qubits de silicio y con una potencia de apenas 12 qubits, casi mil veces menos que el próximo chip Flamingo de IBM. Esta tecnología le exigirá a Intel en mejorar sus procesos pues los qubits de silicio se presentan como pequeños puntos cuánticos que atrapan electrones individuales para almacenar información.

Una mirada al futuro cuántico

Es difícil predecir con certeza los futuros desarrollos e innovaciones en el campo de los computadores cuánticos, ya que la investigación y el avance tecnológico están en curso. Sin embargo, se espera que haya avances significativos en varias áreas. A continuación, se presentan algunas posibles áreas de desarrollo e innovación en computación cuántica:

- Aumento en la cantidad de qubits: Los investigadores están trabajando para aumentar el número de qubits en los computadores cuánticos, lo que permitiría abordar problemas más complejos y realizar cálculos más sofisticados.

- Mejora en la estabilidad y calidad de los qubits: Se están realizando esfuerzos para mejorar la estabilidad y la coherencia de los qubits, reduciendo los errores y aumentando la precisión de los cálculos cuánticos.

- Desarrollo de algoritmos y aplicaciones cuánticas más avanzadas: A medida que se comprenden mejor los principios y las capacidades de la computación cuántica, se espera que se desarrollen algoritmos y aplicaciones más sofisticados que aprovechen plenamente el potencial de los computadores cuánticos.

- Mejora en la corrección de errores cuánticos: Los errores cuánticos son una de las principales barreras para la construcción de computadores cuánticos más potentes. Se están investigando y desarrollando técnicas de corrección de errores cuánticos para mitigar este desafío y mejorar la confiabilidad y precisión de los cálculos cuánticos.

- Investigación en nuevas plataformas de qubits: Además de las tecnologías de qubits existentes, como los qubits superconductores o los qubits de iones atrapados, se están investigando y desarrollando nuevas plataformas de qubits, como los qubits basados en topología o los qubits de estado sólido, que podrían ofrecer beneficios en términos de escalabilidad y control.

Al cierre

La computación cuántica representa un emocionante campo de investigación y desarrollo con el potencial de revolucionar la forma en que abordamos los problemas complejos en ciencia y tecnología. A través de la utilización de qubits y la explotación de los principios de la física cuántica, los computadores cuánticos nos permiten explorar soluciones más rápidas y eficientes para problemas que actualmente están más allá del alcance de las computadoras clásicas.

La intersección entre la computación cuántica y la inteligencia artificial es particularmente emocionante, ya que podría abrir nuevas puertas hacia el desarrollo de algoritmos más avanzados y eficientes, así como impulsar el campo de la IA hacia otros horizontes.

En conclusión, la computación cuántica está en constante evolución y su potencial es aún incalculable. A medida que los investigadores y científicos continúan explorando y desarrollando nuevas tecnologías cuánticas, se espera que la integración de la computación cuántica y la inteligencia artificial genere avances significativos en una amplia gama de campos científicos y tecnológicos.

Fuente: El Autor escribe para el Portal Otras Voces en Educación

Users Today : 19

Users Today : 19 Total Users : 35460150

Total Users : 35460150 Views Today : 32

Views Today : 32 Total views : 3418815

Total views : 3418815