Por Andrés Peri

Hace más de diez años que soy director de la División de Investigación, Evaluación y Estadística (DIEE)(1) de la Administración Nacional de Educación Pública (ANEP). Me gusta mi trabajo. Soy un agradecido de contar con un equipo excelente de profesionales y de trabajar en la dificilísima articulación entre la ciencia y la política. El día después de presentar los resultados de PISA y cuando surgió la polémica sobre ellos, alguien me dijo que no quería estar en mis zapatos. Yo sí quiero seguir luciéndolos; me trajeron hasta acá, y ninguna de las mezquindades del mundo me los va a sacar. Intentaré en esta nota desenredar el malentendido generado.

Los resultados de PISA son siempre una sorpresa. Son el producto de 6.062 adolescentes que se enfrentaron a una tarea nueva. No tenían que estudiar para la prueba, sino que la prueba quería evaluar “qué pueden hacer con lo que saben”. A su vez, lo que incide para que a un estudiante le vaya bien en una prueba de estas características hay que rastrearlo en factores que se empiezan a gestar desde la concepción hasta el día de la prueba. La competencia lectora depende del lenguaje hablado por la familia en los primeros años de vida, de la adquisición de la lectura fluida en los primeros años de la escolaridad, de realizar exitosamente la transición de aprender a leer a leer para aprender alrededor de la mitad de la educación primaria, y depende mucho de si la persona es incentivada a la lectura por placer. La escuela cumple un rol fundamental, pero también la sociedad. Lo mismo podría decirse de las competencias matemática y científica, aunque hay acuerdo en que el rol de la escuela en estos dominios últimos es aun más relevante.

Muchos esperaban un resultado negativo. Algunos lo veían como munición política. Es tan importante que el sistema educativo haya aprendido, recientemente, a valorar lo que las pruebas PISA pueden -y no pueden, ya que no son la única forma de evaluar-, como que el sistema político y los medios de prensa lo entiendan y colaboren en no hacer del ejercicio un espacio de contienda política de corto plazo. Los problemas que enfrenta la educación están presentes y no desaparecen por una mejora en las pruebas PISA, como tampoco se hacen apocalípticos por lo contrario. Lo que PISA nos ofrece es una herramienta para entender, en parte, por qué nuestros resultados se comportan de tal o cual manera.

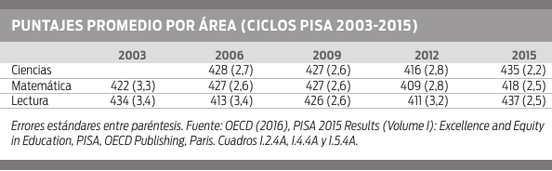

Los resultados fueron presentados de la misma forma por nosotros y por la Organización para la Cooperación y el Desarrollo Económicos (OCDE) en todos los ciclos anteriores basados en el informe internacional. En la tabla se presentan los puntajes del país para cada ciclo en que participó Uruguay.

De la misma forma que se toma el último valor de desempleo y se lo compara con el mes anterior y con la tendencia pasada, si uno mira la tabla concluye que Uruguay mejora sobre 2012 en todas las áreas (coyuntura de tres años), y si analiza toda la serie concluye que el resultado de 2015 es el mayor valor de la serie en Ciencias y en Lectura.

Después uno analiza si las comparaciones con los ciclos anteriores son estadísticamente significativas. En este caso, lo que corresponde comparar es el ciclo anterior y el año en que el área fue foco.(2) Para Ciencias, por ejemplo, la diferencia es significativa para el año anterior, pero no significativa cuando se la compara con 2006. En el caso de Lectura, la diferencia es significativa(3) tanto para 2012 como para 2009, cuando fue área foco.

Las percepciones sobre el sistema educativo son mayoritariamente negativas. He visto experiencias muy valiosas que no logran hacer mella en “el estado del alma” sobre la educación que se instaló en Uruguay. PISA no podía ser una excepción. Pedro Ravela encontró en la página 308 del anexo del informe internacional un ejercicio metodológico con el cual se reescala la serie de resultados para atrás y se analiza qué habría pasado si los cambios introducidos por la metodología 2015 se hubieran aplicado a los ciclos anteriores. En ese ejercicio de simulación los resultados cambian, y la serie muestra una tendencia distinta a la que reporta el informe internacional (que fue el mismo que publicaron Uruguay, Chile y Colombia) en el Cuadro Tabla I.4.4A. Si esta metodología fuese la que se debería adoptar, entonces la OCDE no debería haber publicado el cuadro anterior con la misma metodología que utilizamos nosotros.

Los valores ajustados que presentó en la prensa Pedro Ravela son parte de este ejercicio de simulación, y no forman parte del Volumen I impreso que publicó la OCDE el 6 de diciembre. Sí aparece un link a un sistema de información que tiene la OCDE para ver tablas comparativas. Invito a todos los lectores -y a los colegas técnicos en particular- a ver si algún país informó la tendencia en base a esa corrección. Nosotros hemos hecho una consulta a la OCDE, y la respuesta de Andreas Schleicher (director de Educación de la OCDE) fue la siguiente: “La comparación con el Anexo A5 no debe utilizarse para arrojar dudas sino para comprender las fuentes de esa mejora”.

Como en tantos otros temas, no vemos la luna sino el dedo que la señala. Los temas que tratamos son complejos: es muy difícil medir una competencia por medio de actividades propuestas a estudiantes, y más aun monitorearlas a lo largo de una década en medio de cambios de todo tipo. Insisto: todo lo analizado se hizo como lo plantea la OCDE en su informe central. Las inferencias de mejora se basaron en los datos publicados y en los análisis realizados.

Cuando decante el polvo, ¿qué quedará? ¿Podremos encaminar el debate hacia cómo mejorar, cómo hacer para que un estudiante pueda enfrentarse a una actividad científica y pueda resolverla, cómo atacamos la desigualdad que persiste en nuestro sistema y que cada tres años PISA nos recuerda? El ciclo 2015 mostró mejoras entre los estudiantes de los sectores más vulnerables. Hay ofertas educativas que crecen más de 50 puntos entre 2012 y 2015. Persiste, sin embargo, un fuerte gradiente entre origen social y logros, y un importante porcentaje de estudiantes que no alcanzan resultados de competencia básica. Antes que debatir si hay razones para alegrarse o para preocuparse, yo señalaría que hay razones y evidencia para ocuparse. Ocuparse de identificar nuestros problemas persistentes y atacarlos; ocuparse de entender las causas de las mejoras y potenciarlas. Michael Fullan recomendaba a todos los actores educativos no distraerse. Intentemos volver al foco.

(1). DIEE es la unidad encargada de realizar las evaluaciones internacionales de aprendizaje en las que la ANEP decide participar. Tiene dos departamentos, uno de Evaluación de Aprendizajes y otro de Investigación y Estadística. (2). PISA rota cada tres años el área foco entre Ciencias, Lectura y Matemática. (3). Se denomina “diferencia significativa” cuando se aplica un procedimiento estadístico que descarta la variabilidad inherente a trabajar con muestras.

Fuente:http://ladiaria.com.uy/articulo/2016/12/pisa-y-el-debate-educativo-volver-al-foco/

Imagen: ladiaria.com.uy/media/photologue/photos/cache/puntajes_pisa_article_main.png

Users Today : 124

Users Today : 124 Total Users : 35459590

Total Users : 35459590 Views Today : 201

Views Today : 201 Total views : 3417959

Total views : 3417959