América del Norte /EEUU/Julio del 2016/Maryann P. Feldman/file:///C:/Users/Administrador

A lo largo de la Historia, el hombre ha buscado formas de transmitir información a lugares adonde no podía llegar su voz, reduciendo los costes y mejorando la calidad. Partiendo de la palabra escrita y siguiendo con la invención de la imprenta, las tecnologías de la información y comunicación (TIC) han ido cambiando en rápida sucesión: el telégrafo, la radio, el teléfono, el fax y, últimamente, Internet.

Antiguamente, las personas, para comunicarse, tenían que estar cara a cara, pero ahora la tecnología hace posible el intercambio de información a gran distancia y permite su almacenamiento y transmisión así como el acceso a un contexto más avanzado y complejo.

El resultado es que la comunicación se ha abaratado y, en consecuencia, las relaciones económicas y las negociaciones a través del espacio geográfico son más fluidas. Actividades muy alejadas desde el punto de vista geográfico pueden entrar en contacto con toda facilidad. La distancia geográfic a ya no supone falta de información. Internet y, de manera más general, las tecnologías digitales de la información, auguran mayores cambios en la organización de las actividades económicas, cambios tan profundos que merecen el nombre de revolución.

La información se puede recoger, almacenar, procesar, comunicar y emplear con más facilidad. Es de esperar que el coste cada vez menor de la comunicación produzca más intercambios, mejor acceso a la información, mayor autonomía personal en las decisiones sobre dónde residir y, en última instancia, una mayor difusión de la actividad económica.

Las repercusiones de Internet serán diferentes en las distintas industrias y en los diversos tipos de actividades económicas. Este artículo trata de la localización de la innovación, una actividad económica especialmente basada en el conocimiento.

La tendencia de la actividad innovadora a agruparse espacialmente es bien conocida y se identifica con lugares como Silicon Valley, Research Triangle Park, Route 128, en Boston, Estados Unidos, Wireless Valley en Finlandia, Oxbridge en Inglaterra, y Singapur, entre otros.

Los economistas llevan estudiando este fenómeno desde Marshall (1890) y más recientemente, han estudiado los motivos por los cuales los lugares de alta renta y altos salarios como Nueva York, San Francisco, Londres, París y otras ciudades importantes siguen creciendo y siendo direcciones favoritas (Feldman 2000 ofrece una revisión de la literatura sobre este tema). Hasta la fecha, existen pocos estudios empíricos que analicen cómo van a influir las TIC en los modelos de localización de la actividad económica.

El objetivo de este artículo es ofrecer un marco para considerar cómo puede influir Internet en la localización de la actividad innovadora y en concreto si ésta se dispersará debido a Internet y a las tecnologías digitales. En el próximo apartado se analiza la repercusión que ha tenido Internet hasta ahora. Internet ha facilitado el intercambio de información, ha hecho que la administración de los negocios sea más eficaz y que el consumidor tenga mayor elección, y ha tenido, y seguirá teniendo, consecuencias profundas en la productividad que, en general, han sido favorables para las actividades económicas de rutina.

A diferencia de éstas, la innovación se basa en la creación de conocimiento y en su puesta en práctica. Se tata, básicamente, de un proceso social que pone en relación a individuos de diferentes disciplinas, con diferentes competencias, distintos vocabularios y la misma motivación. La innovación implica creatividad y es un proceso cognitivo. Internet ofrece los instrumentos para que los individuos accedan a la información con facilidad y, por lo tanto, ayuda a la actividad innovadora, pero existen factores como el conocimiento tácito y la índole socia l del proceso de innovación que limitan el impacto de Internet.

La geografía ofrece el espacio físico en el que se organizan los individuos y los recursos y se contienen las externalidades positivas asociadas a la creación del conocimiento. Por lo tanto, estudiaremos la repercusión de Internet en la innovación en tres planos: el individual, el social y el geográfico. Entender la revolución de Internet Vivimos en una era de comunicaciones mundiales fáciles, de acceso instantáneo a la información y de capacidad de almacenar, buscar, y manipular grandes cantidades de información.

Según el Bureau of Labour Statistics de los Estados Unidos, en 1999, el sector de las Tecnologías de Información y Comunicación (TIC) pasó a ser el sector comercial más importante de los Estados Unidos, con un índice de crecimiento del empleo equivalente a seis veces el promedio nacional. Alan Greenspan, Presidente de la Reserva Federal de los Estados Unidos cree que el crecimiento del negocio de las TIC ha supuesto al menos un tercio del crecimiento total de la economía del país desde 1992.

El sector de las TIC representa una variedad de productos, tecnologías y servicios basados en descubrimientos científicos en el campo de los ordenadores, diseño de software, óptica y fotografía, conmutación de circuitos y satélites entre otros. La representación más visible de la Revolución de las TIC es Internet, que integra los ordenadores y las telecomunicaciones. Lo más llamativo es la aceleración del índice de aceptación de las TIC. La radio llevaba existiendo 38 años cuando llegó a un mercado de 50 millones. Dieciséis años han transcurrido desde que se vendió el primer ordenador personal en 1973 hasta llegar a los 50 millones de usuarios actuales. Cuando Internet se abrió al tráfico comercial en 1993, alcanzó esta cifra en cuatro años.

Una aplicación concreta, Napster, un protocolo para transferir archivos de música, registró 25 millones de usuarios al año de su introducción. Gracias a Internet, todo el que pueda realizar una pequeña inversión de capital en un ordenador y en acceder a un servidor puede conectarse con otros ordenadores de todo el mundo en una red interconectada de máquinas, datos y personas. Se cree que en el año 2002, la WWW contará con 320 millones de usuarios (Lange, 1999: 35).

El número de mensajes enviados a través del correo electrónico es de 6,5 billones al día en todo el mundo y el crecimiento será exponencial a medida que haya más usuarios conectados. Además, la tecnología sin cable está avanzando, lo que rebajará aún más los costes de la conexión, y atraerá potencialmente a más usuarios al mundo digital.

La información digital es compacta y transportable y, por lo tanto, más eficiente. Los economistas señalan que lo costoso de la información es su creación, pero una vez creada, el coste de reproducirla y transmitirla es prácticamente nulo. Se pueden hacer múltiples copias y lo difícil es controlar la difusión y el acceso, contrariamente a los productos físicos que los economistas suelen estudiar. La facilidad de transmitir información suscita una serie de problemas sobre la protección y el buen uso de la propiedad intelectual, y sobre la intimidad, el acceso sin autorización y la piratería de datos. Hasta ahora, hay pocos estudios empíricos que analicen el uso que las empresas hacen de Internet.

Litan y Rivlin (2001) estudian el impacto de Internet en diferentes sectores y señalan tres impactos económicos distintos: la disminución del coste de las transacciones; la mayor facilidad de gestión; y el acercamiento de la economía al modelo de la competencia perfecta. La principal consecuencia de Internet ha sido el abaratamiento de las transacciones.

El comercio por Internet, más rápido que el realizado por el correo convencional y más exacto que el telefónico, se basa en la rapidez y facilidad con que se intercambia y coordina la información sobre las transacciones entre las empresas y sus proveedores y clientes. Desde el punto de vista de las empresas, Internet reduce los costes de las compras, los inventarios y los tiempos y también los costes de venta y marketing y aumenta la efectividad y eficiencia de los controles de los servicios al cliente y de los materiales de venta.

Desde el punto de vista de los consumidores, Internet ofrece una mayor elección, adecuación y posibilidades de una mayor personalización. En segundo lugar, Internet, al facilitar el acceso a la información, la búsqueda de ésta y su comunicación, permite una administración más eficiente.

La información en forma digital es más fácil de emplear que en la forma alternativa sobre papel. Esto ha reducido enormemente los costes para las empresas en lo referente a sus rutinas de registros internos, control de inventarios y procesamiento de las transacciones. Por último, Internet está acercando la economía al mode lo ideal de la competencia perfecta según los economistas, lo que implica una mayor eficiencia. Es más fácil para los proveedores y consumidores encontrar información unos sobre otros, buscar alternativas y realizar las transacciones. Este acceso directo reduce la necesidad de intermediarios y distribuidores. Cabe esperar que el hecho de que haya más información, más elección, y de que los costes de las operaciones y transacciones sean menores, se traduzca en una bajada de los precios y un aumento de la calidad.

En resumen, se espera que estos tres factores contribuyan a la economía de los Estados Unidos con una tasa anual de entre 2 y 4% del crecimiento futuro de la productividad. Además, Internet y la distribución digital pueden originar nuevos productos o servicios insospechados hasta ahora, lo que supondrá incrementos aún mayores del desarrollo económico (Economist 2000).

Las repercusiones económicas de Internet son profundas, pero afectan a las actividades económicas rutinarias que se basan en los flujos de información con parámetros bien definidos y con un contenido relativamente estándar. Ahora bien, la innovación es un tipo especial de actividad no rutinaria y cabe esperar que Internet tenga en ella una repercusión diferente. La innovación, el conocimiento y la información Empezaremos por ver qué entienden los estudiosos por innovación, palabra muy usada en el lenguaje moderno.

La innovación es un tipo determinado de actividad económica destinada a la elaboración de productos, procedimientos o métodos de organización nuevos –un toque de origen humano que produce originalidad y unicidad. La innovación se relaciona normalmente con aplicaciones comerciales y hay que distinguir entre invención, la idea original, y la innovación, su realización comercial. No todas las actividades de invención tienen una aplicación comercial, pero en toda innovación hay, desde luego, una parte de invención.

El ínsumo más decisivo para la innovación es el conocimiento. Mientras la información es el flujo de datos, el conocimiento es una información almacenada que se organiza en un esquema conceptual. La innovación es la capacidad de mezclar y combinar diferentes tipos de conocimientos en algo nuevo, diferente y sin precedentes, que tiene un valor económico. Parecida al arte , la innovación es una expresión creativa; pero, a diferencia de aquél, la valoración de la innovación no depende del espectador, sino de su aceptación en el mercado, que otorga una recompensa comercial a las entidades innovadoras, y repercute en la sociedad en términos de bienestar económico, prosperidad y desarrollo.

La naturaleza del proceso de innovación Transmitir la información a grandes distancias es fácil, pero transformarla en conocimiento utilizable es un proceso cognitivo más complejo. La información consiste en saber algo, en conocer unos datos. El conocimiento existe cuando un individuo sabe qué hacer con la información, lo que implica, cuáles son sus limitaciones y cómo crear algo de valor partiendo de ella. Consideremos el ejemplo sencillo de la previsión sobre el tiempo, en su aspecto informativo. Saber qué ropa ponerse o si hay que llevar paraguas requiere un conocimiento. Para una actividad corriente, todo el mundo con el conocimiento necesario sabe emplear la información y es fácil transmitir ésta de manera que sea utilizable.

Es el caso de una actividad estándar o rutinaria. Por el contrario, la innovación implica una actividad nueva y hay una gran dosis de inseguridad en la aplicación de la información. Consideremos el caso de un nuevo descubrimiento. Un científico trabajando en su laboratorio puede alcanzar algo sin precedentes, el típico momento del ¡EUREKA! En este primer momento, puede no haber ni siquiera el léxico o vocabulario adecuados para comunicar los conceptos clave.

En el nivel más básico, la innovación y la creatividad tienen lugar en la mente del individuo y se basan en la síntesis de la información y en la transformación de ésta en las formas existentes de ver el mundo o esquemas cognitivos. En el congreso de “Hackers”, Las Vegas, USA Jeanne Hilary / RAPHO Todas las actividades de resolución de problemas emplean modelos cognitivos para discernir la información valiosa y saber cómo organizar ésta de manera provechosa. El proceso de entender y dar sentido a la nueva información requiere la transformación de ésta en algo significativo para el individuo, y entraña el hacerse preguntas, recurrir a las analogías y entender el contexto.

Es un proceso complejo de tanteo, retroalimentación y evaluación que se ve muy favorecido por la interacción presencial. La innovación, en tanto que proceso cognitivo y social, requiere estos tipos de interacciones recíprocas y complejas que dan lugar a discusiones, clarificaciones y nuevas conceptualizaciones a medida que una idea se va convirtiendo en innovación. Cuando los individuos trabajan en un problema, desarrollan un lenguaje y unos marcos de referencia comunes.

En consecuencia, es posible incorporar nueva información a estas estructuras cognitivas y acumular de manera efectiva el conocimiento que facilita la innovación. Si el conocimiento es tácito o inseguro, mucha información se comunica a través de los gestos, la expresión facial y el tono de voz. Estos matices son pistas importantes para entender el significado y el contexto y son posibles gracias a la interacción directa cara a cara.

Cuando el conocimiento puede ser codificado, es más fácil transmitirlo a los demás en todo tipo de medios. De las actividades económicas, la innovación es aquélla a la que más afecta la localización, precisamente por su naturaleza creativa y por basarse en el conocimiento tácito. La mayor tendencia hacia la concentración geográfica se da en las industrias nuevas y en las primeras fases de su ciclo vital. Cuando las actividades se van haciendo estándares o más rutinarias, se puede observar claramente una menor tendencia a la concentración geográfica.

Desde luego, Internet favorecerá la actividad innovadora pues la enorme cantidad de información que ofrece y el fácil acceso a ella es un elemento muy valioso para el trabajo creativo. Ahora bien, aunque las video-conferencias y el contenido de la web se perfeccionan sin cesar, no equivalen a participar en persona.

Todo el que ha estado alguna vez en Internet ha experimentado la satisfacción de encontrar cosas nuevas que se le ofrecen como si dispusiera de un ayudante personal, pero también la frustración de no conseguir la información que deseaba. En un nivel básico, la información en Internet viene dada en las páginas web, un archivo HTLM (hypertext markup language) y unos archivos asociados para escritura y gráficos que suelen tener otros muchos enlaces con otros documentos de la Web y con navegadores y motores de búsqueda.

Los contenidos que ofrecen las páginas web, por las que se comunica la información de Internet, son muy estándares y deben ser organizados y ordenados por prioridades. El equipo de diseño técnico y ayuda para hacer una página web hace juicios de valor sobre las prioridades y necesidades de los usuarios e interpreta el marco de referencia.

Los elementos esenciales del diálogo parecen estar definidos de antemano. Por ejemplo, los diseñadores de páginas web deciden qué enlaces ofrecer y las preguntas se limitan a lo que los diseñadores de las web consideran que puede plantear problemas. La mayoría de los sitios web tiene n una lista con las preguntas más frecuentes (FAQ [frequently asked questions]) para ayudar a los individuos a usar e interpretar la información. Las FAQ son un medio de proporcionar respuestas anticipándose a las preguntas más usuales. Se pide a los usuarios que lean detenidamente las FAQ antes de recurrir al correo electrónico o al teléfono para hacer una pregunta.

Para elaborar las FAQ es preciso haber hecho una selección de las preguntas de los usuarios llegando así a la estandarización de preguntas y respuestas. Esto requiere que el programador o analista de sistemas caractericen al usuario y el uso que éste hará de la información obtenida. Desde luego, con una transacción de rutina como comprobar las horas de las películas o hacer una compra, esto no plantea problema. Pero un conocimiento más tácito, como la solución a un problema complejo o el asesoramiento sobre cómo definir un problema tiene un grado mayor de inseguridad.

En este caso, es más difícil transmitir el significado exacto, pues se requiere interpretación y aclaración, por lo que es difícil de comunicar en un medio estandarizado. Cuando el conocimiento es muy tácito por naturaleza, la interacción y la comunicación cara a cara (y, por lo tanto, la proximidad geográfica) son favorecen la transmisión del conocimiento. Cuanto menos codificado es el conocimiento y más difícil formularlo, mayor es la necesidad de contactos personales frecuentes y mayor el grado resultante de centralización en la organización geográfica. A medida que la tecnología se hace más sofisticada, se puede introducir más cantidad de contenido, pero existen limitaciones que dan la ventaja a la interacción humana directa.

Los diseñadores de las páginas web emplean una interfaz que se caracteriza por la frase What You See Is What You Get [Lo que ves es lo que tienes] (WYSIWYG), que hace referencia al protocolo de diseño comúnmente utilizado o a la interfaz de usuario que no requiere códigos intrincados ni órdenes complicadas. Es útil, a medida que aumenta el número de individuos que pueden hacer páginas web, pero, como ocurre con toda estandarización, esto tiene un coste.

Para el caso peor se emplea la frase What You See Is All You Get [Lo que ves es todo lo que hay] (WUSIAYG), una versión más pobre a la que le falta profundidad y flexibilidad. Para atraer a los mercados de masas, el contenido debe tener un atractivo muy general lo que significa dirigirse a un mínimo común denominador. La alta calidad del contenido, heredada de los primeros usuarios, científicos y universitarios, parece próxima a desaparecer debido a la mayor presencia comercial en Internet. La innovación como proceso social localizado La innovación, más que el producto del trabajo individual de un inventor es el resultado de la ordenación de corrientes de conocimiento diferentes y complementarias.

Saxenian (1990, p. 96-97) estudiando las redes de Silicon Valley, California, insiste en que es la comunicación entre los individuos lo que facilita la transmisión del conocimiento entre los agentes, las empresas e incluso las fábricas. “No es solamente la concentración de trabajadores cualificados, proveedores e información lo que distingue a esta región, sino que hay toda una serie de instituciones regionales –entre otras la Stanford University, asociaciones comerciale s diversas, organizaciones locales de empresas y un sinnúmero de consultorías especializadas, empresas de estudios de mercado, de relaciones públicas y de capital de riesgo – que ofrecen servicios técnicos, financieros y de redes que las empresas de la región no siempre pueden pagar individualmente.

Estas redes desafían las barreras sectoriales: los individuos cambian con facilidad, pasando de empresas de semiconductores a empresas de unidad de disco, o de fabricantes de ordenadores a creadores de redes. Pasan de empresas establecidas a otras que empiezan (o viceversa) e incluso a empresas de estudios de mercado o asesoría y de éstas nuevamente a empresas que empiezan.

Y siguen encontrándose en ferias comerciales, conferencias industriales y en innumerables seminarios, charlas y actividades sociales promovidos por organizaciones locales de empresas y asociaciones comerciales.

En estos foros, es fácil establecer relaciones y cultivarlas, intercambiar información técnica y de mercado, y hacer nuevos contactos de negocios, con lo que surgen nuevas empresas… Este entorno descentralizado y fluido favorece también la difusión de capacidades y conocimientos tecnológicos intangibles.”

Como resultado de todo esto, existen redes sociales, definidas como una “colectividad de individuos entre los cuales tienen lugar intercambios basados tan sólo en normas compartidas de comportamiento leal” (Liebeskind et al., 1995:7). La concentración facilita los contactos sociales necesarios para el desarrollo de estas redes y reduce los costes de los controles de conductas desleales.

Resulta mucho más difícil mantener la confianza a grandes distancias y con los sistemas de cifrado de los medios digitales; las firmas digitales y otras soluciones técnicas tratan de ofrecer una información precisa, válida y fiable, pero con ello, la confianza se convierte en algo mediatizado por la tecnología, dejando de depender del libre albedrío del individuo.

En este caso, la localización geográfica sirve también para controlar la actividad de otras empresas, ya sean de proveedores, de socios o de la competencia. Una página web presentada profesionalmente puede dar legitimidad a una empresa virtual. Hay un dibujo en el New Yorker en el que aparecen dos perros trabajando en sendos ordenadores.

El texto dice “En Internet nadie sabe que Ud. es un perro”. Aunque la falta de vigilancia implica libertad por un lado, también suscita problemas de confianza, seguridad e integridad de la información. La ventaja de ver las cosas con los propios ojos, tocar el producto y palpar la mercancía, es que confiamos en nuestras propias percepciones.

La interacción y la observación frecuentes, la confirmación y comprobación de las fuentes conocidas junto con la posibilidad de control, son algunas ventajas de la proximidad física. Veamos el caso del capital de riesgo en el proceso de innovación. Pocas empresas que están empezando reciben capital de riesgo, pero éste ofrece financiación, contactos con los recursos clave y asesoramiento en operaciones, cosas todas ellas muy útiles para las empresas innovadoras de nueva creación.

Los capitalistas de riesgo tienden a hacer sus inversiones en el ámbito local porque financiar una nueva empresa supone un posible peligro (Sahlman 1990). Los empresarios tienen un conocimiento profundo de la empresa y un gran interés en que su información coincida con lo que creen que el inversor de capital de riesgo desea oír para, de esta forma, no poner en peligro la relación financiera.

El resultado es una asimetría de información, a menos que el capitalista de riesgo pueda controlar de cerca la nueva empresa y hacer una valoración informada. El control requiere ver con los propios ojos, presentarse de forma inesperada, y hacer una valoración independiente. La necesidad que tienen los capitalistas de riesgo de controlar las nuevas empresas en las que invierten, hace que la proximidad geográfica sea un valor en sí mismo (Gompers y Lerner 1999). Un tema de gran importancia y actualidad es la seguridad de la información, la búsqueda de nuevos métodos para garantizar la integridad y precisión de los datos.

En relación con esto está el problema de la intimidad, pues la correspondencia personal, los registros digitales y los envíos por la web se convierten en datos acerca de un individuo que pueden ser utilizados con otros fines (Rosen 199). Los científicos informáticos trabajan en tecnologías criptográficas cada vez más sofisticadas, pero existe la creencia de que la tecnología por sí sola no será capaz de ofrecer una total seguridad, sino que se necesita el apoyo de las instituciones sociales (Schneier 2000).

La interceptación y violación de los códigos secretos para transmitir los datos tiene una larga tradición histórica que Kahn (1996) y otros han señalado. Desde el momento en que la gente envía mensajes, sea por el medio que sea, siempre hay otros individuos que intentan acceder a ese material sin autorización.

Uno de los inconvenientes más graves para la seguridad en Internet es la incapacidad de la gente para emplear múltiples contraseñas y cambiarla s con frecuencia. Los problemas de la seguridad de la información son el motivo mencionado con más frecuencia para no hacer transacciones comerciales por Internet.

Si nos resistimos a compartir nuestros datos financieros, ¿estaremos dispuestos a compartir otros secretos? Internet ofrece información a todo el mundo desde el momento en que accede a la Web. Cuando la información está al alcance de cualquiera, presumiblemente pierde todo valor estratégico concreto, se convierte en un producto. Si un área técnica está en situación de cambio, con un índice elevado de obsolescencia del conocimiento, puede haber una tendencia a retrasar la disponibilidad de la información hasta que emerja un diseño dominante o hasta que se obtenga alguna ventaja estratégica de divulgar la información.

Por ejemplo, vemos que en algunas industrias existe una tendencia a retrasar la solicitud de patente porque en ella se revela demasiada información acerca de la tecnología. Las empresas prefieren tener la ventaja de ser las primeras de l mercado manteniendo los flujos de información bajo control hasta que la innovación esté ultimada.

Así pues, los actores económicos entran en “carreras” para ser los primeros en llegar al mercado y obtener las compensaciones económicas correspondientes, sin comunicar en línea su información más valiosa. La geografía, plataforma para organizar la innovación En 1890, Alfred Marshall señalaba la importancia de la concentración, una especie de economía de escala externa que se suma a la localización geográfica para la actividad económica, y muchos economistas que estudian la innovación y su localización apelan a la lógica de Marshall: “Cuando una industria ha elegido una localidad por sí misma, lo probable es que permanezca en ella durante mucho tiempo pues son muchas las ventajas de que la gente que se dedica al mismo negocio esté en contacto.

Los misterios del negocio dejan de ser misterios; pero es como si estuvieran en la atmósfera, y los niños, aprenden muchos de ellos sin darse cuenta. Se aprecia el buen trabajo, y enseguida se habla de los méritos de las invenciones y mejoras en la maquinaria, en los procedimientos o en la organización general de los negocios; si alguien pone en marcha una idea nueva, otro la toma y le añade sus propias sugerencias, convirtiéndose así en una fuente de más ideas nuevas. Y en el vecindario, proliferan las empresas subsidiarias que proveen los accesorios y materiales, organizan el comercio de éstos, y dirigen la economía hacia ellos de muchas maneras”.

Marshall escribía tras la aceptación general del telégrafo y sus observaciones siguen siendo válidas en contraste con las predicciones sobre el impacto del telégrafo. El impacto esperado del telégrafo refleja las predicciones actuales sobre Internet tan exactamente que Tom Standage (1999) llama al telégrafo la Internet victoriana.

Un funcionario que defendía la línea transatlántica predijo: “Todos los habitantes de la tierra entrarán en una vecindad intelectual” (Jackman en 1846, citado en Standage 1999). Scientific American se refería en 1858 al telégrafo atlántico como “la autopista instantánea del pensamiento entre el Viejo y el Nuevo Mundo.” Cien años después, los economistas siguen encontrando pruebas empíricas de un aspecto espacial de la innovación.

En lenguaje popular, a esta concentración de la actividad innovadora se le llama el fenómeno de Silicon Valley debido a la prominencia del desarrollo de la industria de los ordenadores en Santa Clara, California, en las proximidades de la Stanford University. La concentración espacial alcanza a una gran variedad de actividades innovadoras en una serie de industrias y sectores, poniendo de manifiesto la importancia de la especialización regional para la actividad económica, y de las concentraciones geográficas para producir mayores beneficios, así como las consecuencias en la productividad, que se derivan de la localización conjunta de la investigación y el desarrollo de las empresas y de las universidades. Centrémonos en el caso de Internet.

El principio de la historia de Internet se suele situar en la elaboración de un conmutador de paquetes y la creación de la Red Avanzada de Proyectos de Investigación (ARPANET) en el Departamento de Defensa de los Estados Unidos en el decenio de 1960, y tarda varios decenios en desarrollarse. Abate (2000) demuestra la función de los usuarios individuales y las redes sociales en la configuración de la red para alcanzar sus propios objetivos y en la definición y redefinición constante de la arquitectura y el concepto de lo que Internet ha llegado a ser. Las aplicaciones como el correo electrónico y la World Wide Web se crearon de manera informal sin una planificación formal coordinada. No es de extrañar que las empresas que trabajan en las aplicaciones de Internet estén concentradas geográficamente en algunas localizaciones prominentes de los Estados Unidos y en todo el mundo (Zook 2000; Pelletiere y Rodrigo 2001).

Existe una relación directa entre la propensión de las industrias a la concentración geográfica y la intensidad del conocimiento en la actividad de la industria. La importancia de la situación geográfica depende del ritmo con el que las nuevas ideas reemplazan a las viejas, es decir, de la obsolescencia del conocimiento. El capital intelectual, exactamente igual que el físico, se deprecia y queda obsoleto. Las industrias que experimentan elevados índices de obsolescencia del conocimiento se benefician si se sitúan cerca de las fuentes de nuevos conocimientos, de manera que puedan estar al tanto de las nuevas ideas y evaluarlas. Como era de esperar, los trabajos empíricos de investigación llegan al resultado de que las industrias que experimentan una rápida depreciación del conocimiento y una alta oportunidad tecnológica, tienen un alto grado de concentración espacial.

Esto se aplica de manera especial a las empresas que están en las primeras fases de su ciclo vital cuando el ritmo de innovación es rápido. La revolución de las telecomunicaciones posibilita la rápida transferencia del trabajo a todo el mundo. Empresas como Cisco Systems Inc., Deutsche Bank, IBM Corp.

, Nortel Networks Ltd., o Tektronix transfieren trabajo a diferentes localidades de todo el mundo para beneficiarse de los tres cambios de turno del día. Se puede empezar un trabajo de programación en Silicon Valley y transferirlo a Bangalore, India, pues el final de una jornada laboral corresponde con el inicio de otra. Así se repite el proceso, transfiriendo el trabajo a Irlanda para el tercer cambio de turno del día. El proceso continúa hasta la terminación del producto. Desde luego, es un método muy productivo, pero ¿es innovador? Se puede decir que la escritura de un código, sus comienzos e implantación forman parte de la innovación, pero es esa parte que se puede utilizar varias veces.

Es necesario realizar más trabajos de investigación sobre este tema. Es como si alguien en alguna parte estuviera orquestando el proceso y tuviera la capacidad de tomar decisiones para reaccionar a las crisis y a los problemas inesperados. La teoría predice que ese individuo residiría en una concentración que ofreciera los recursos para hallar soluciones novedosas y encargar el trabajo según sus necesidades. Veamos el libro Geeks: How Two Lost Boys Rode the Internet Out of Idaho escrito por Jon Katz para Wired, una revista difundida por Internet y en papel, dedicada a entender la tecnología de las comunicaciones.

Con la palabra geek se designa a individuos hábiles para la técnica pero ineptos socialmente y su etimología es muy expresiva. El significado original era actor de carnaval que mataba a los pollos cortándoles la cabeza de un mordisco. El empleo de este término da idea de la mala consideración en que se tiene a estos individuos. Pero la situación ha cambiado y la importancia económica de la capacidad técnica ha evolucionado hasta el punto de que los alumnos del Instituto Tecnológico de Massachussets llevan ahora camisetas que proclaman el “Orgullo Geek”. La historia de Katz nos da cuenta de cómo los individuos de localidades remotas pueden dominar una serie de capacidades de esta nueva tecnología y entrar en contacto con un mundo más amplio.

Dos jovencitos brillantes que viven en una comunidad local de la que estaban proscritos, fueron capaces de acceder a una comunidad virtual que reconocía, cultivaba y premiaba su talento. No obstante, al final de la historia, estos individuos se mudan a lugares en los que podían tener una interacción real con sus tutores y con otros individuos con intereses parecidos a los suyos. Las competencias sociales de hackers y geeks pueden no estar bien vistas por la opinión pública, pero no se puede negar que existen y que son sociales. Internet puede ofrecer una vida virtual rica e interesante, ofrece información y contactos a aquellos que viven aislados geográficamente.

Pero no es un sustituto de la vida real. El recurso clave en el proceso de innovación es la formación laboral de individuos que tengan los conocimientos y aptitudes para ser creativos, hacer las preguntas pertinentes, idear nuevas formas y maneras de hacer las cosas, y entender las posibilidades. Desde luego, la concentración geográfica de trabajo cualificado es la condición más difícil de reproducir en regiones que están intentando desarrollar concentraciones industriales de alta tecnología. Los motivos pueden ser que no se trata sólo de las competencias de los individuos, sino de los recursos de que éstos disponen en determinadas localizaciones. La tecnología está avanzando hacia una mayor sofisticación y las dificultades inherentes a la falta de la anchura de banda adecuada tienden a resolverse haciendo que las videoconferencias y el trabajo en colaboración sean más aceptables.

Una pregunta importante sigue: Si pudiera vivir en cualquier lugar y seguir haciendo su trabajo, ¿dónde viviría? ¿Cómo organizaría su vida y su tiempo? Quizá el aspecto más importante de la revolución de las TIC es que nos liberará de la tiranía de las distancias que condicionan y limitan la elección de lugar de residencia.

El término hacker ha venido a significar un amplio movimiento de individuos que son expertos en técnica pero siguen manteniendo el espíritu inconformista. Igual que la ética protestante del trabajo de Weber iba asociada a la Revolución Industrial, la ética hacker va unida a la Revolución de la Información.

Pekka Himanen (2001) en The Hacker Ethic and the Spirit of the Information Age formula una nueva característica de la era de la información relacionada con lo apasionante que puede ser la vida en el plano individual cuando se incorpora la creatividad al trabajo.

La ética hacker se basa en la creencia de que los individuos pueden crear grandes cosas aunando esfuerzos con imaginación. La nueva ética defiende la necesidad de mantener unos estándares y unos ideales éticos y fomentar unos ideales sociales como la intimidad y la igualdad. La palabra hacker en este contexto designa a los entusiastas programadores informáticos que comparten su trabajo, no al tipo de conducta delictiva que algunos individuos consideran un reto.

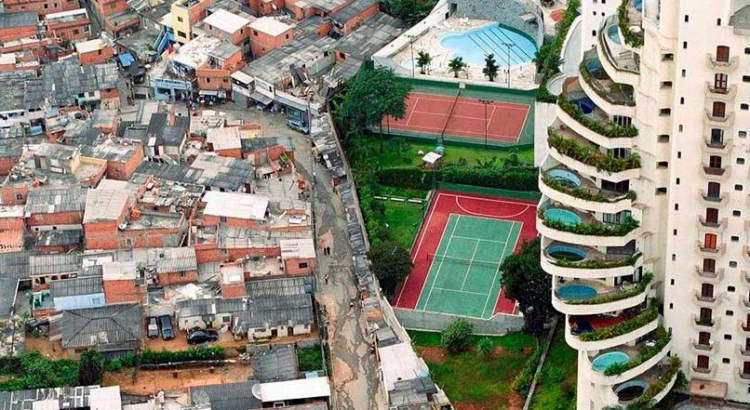

Para este grupo, el ordenador e Internet suponen un nuevo mecanismo de organizar la vida y el trabajo dándoles más sentido. ¿Qué papel tiene la localización en la ética hacker? Desde el momento en que el individuo tiene acceso a la web, su localización inmediata es irrelevante puesto que tiene acceso a toda la información y a los recursos disponibles en la web y puede conversar con todos los demás individuos conectados. Desde luego, hay que reconocer que no todos los individuos están conectados ni tienen acceso a la web. Es cierto que todos los lugares que no pueden conectarse a Internet se irán quedando atrás, lo que va creando una división digital entre los conectados y los no-conectados que sólo puede conducir a exacerbar las desigualdades económicas ya existentes.

El final de la tiranía de las distancias y la importancia cada vez mayor de la localización Cairncross (2001) escribe “La desaparición de las distancias como determinante del coste de las comunicaciones será probablemente la única fuerza económica que configure la sociedad en la primera mitad de este siglo. Influirá, de manera difícilmente imaginable, en las decisiones sobre dónde vivir y trabajar, los conceptos de fronteras nacionales y los modelos de comercio internacional.

La desaparición de las distancias significará que toda actividad que se base en una pantalla (ordenador) o un teléfono, se pueda llevar a cabo en cualquier sitio del mundo”. Pero esto no equivale ni mucho menos a decir que la localización carecerá de importancia. Ciertamente, cabe esperar que cuando las actividades y los actores económicos estén libres de las limitaciones de la ubicación geográfica, ésta quizá cobre más importancia.

Poca gente tendría que vivir en una localidad solamente en razón de su proximidad a los recursos naturales, por cuestiones de transportes o por capricho de su patrono. Es una visión de una utopía en la que Internet y la revolución digital dará a los individuos libertad de elegir su residencia. Shapiro y Varian (1999) defienden que las reglas fundamentales de conducta y la vida económica no han cambiado. Nuestra sociedad se ha acostumbrado a la disminución de costes de la transmisión de información e Internet es sólo una innovación más dentro de otras muchas. Internet es un instrumento y la cuestión es cómo preferiríamos emplearlo.

La pregunta es: si pudiera vivir en cualquier sitio, ¿dónde preferiría vivir? Mi opinión es que, como seres sociales que somos, preferiremos situarnos junto a otros seres parecidos a nosotros, en lugares que ofrezcan las ventajas que cada cual valore, oportunidades interesantes y ese elemento maravilloso de suerte -el encuentro casual, la inesperada taza de café, la revelación sorprendente.

Habrá algunos núcleos de actividad innovadora que serán los lugares más deseables, los sitios más productivos y, el que pueda, querrá vivir en ellos. Al fin y al cabo, somos entidades físicas y no virtuales y necesitamos estar en algún sitio. Internet es un medio nuevo, un instrumento más rápido que permite a los actores desempeñar las actividades que ya venían desempeñando. Es cierto que la vida ha cambiado de bido a Internet, lo mismo que ocurrió con la Revolución Industrial. Pero hay que reconocer que, aunque la Revolución Industrial trajo consigo grandes beneficios económicos y sociales, también produjo una ‘dis-locación’ de la gente a gran escala, cambió los hábitos de trabajo y las condiciones laborales de manera socialmente indeseable en muchos casos, y aumentó la contaminación y la explotación del medio ambiente.

Estamos ahora ante el abismo de la nueva revolución digital y quizá la manera de formular la pregunta es cómo podemos aprovechar esta nueva tecnología para construir una sociedad y una economía de más oportunidades, más libertad y armonía. Los seres humanos, en tanto que seres físicos, tienen que estar en algún espacio geográfico y ahora tenemos los medios para liberarnos de la tiranía de las distancias. Más que intentar predecir el futuro, espero que seamos capaces de emplear estos medios para configurarlo.

Traducido del inglés Agradecimientos *Deseo expresar mi agradecimiento a Dominique Foray por animarme a escribir sobre este tema. Es el tipo de amistad y colaboración a gran distancia facilitada por Internet. También quiero dar las gracias a David Audretsch, Ianin Cockburn y Pierre Desrochers por los debates que hemos mantenido sobre estas cuestiones.

Referencias

ABBATE, J. 2000. Inventing the Internet. [Inventar Internet]Boston: MIT Press.

CAIRNCROSS, F. 2001. The Death of Distance. [La desaparición de las distancias] Boston: Harvard Business School Press.

COMERFORD, R. 2000. “The Internet.” [Internet]. “Internet” IEEE Spectrum 37 (1), Enero: 40-44.

DEPARTMENT OF COMMERCE 1999. Falling through the Digital Divide: Defining the Digital Divide. [Caer en la división digital: definición de la división digital] National Telecommunications and Information Administration: Washington, D.C. http://www.ntia.doc.gov/ntiahome/digitaldivide/.

ECONOMIST 2000. “Internet Economics: A Thinkers Guide.” [La economía de Internet: Guía para pensadores] Abril 1: 64-66.

FELDMAN, M. P. 2000. “Location and innovation: the new economic geography of innovation, spillovers, and agglomeration” [La localización y la innovación: la nueva geografía económica de la innovación, diseminaciones y concentraciones]. En G. Clark, M. Feldman y M. Gertler, editores. Oxford Handbook of Economic Geography, [Manual de Geografía Económica de Oxford] Oxford: Oxford University Press.

GREENSTEIN, S. 2001. “The Commercialization of Internet Access.” [La comercialización del acceso a Internet]. En M. P. Feldman y A. N. Link, editores, Innovation Policy in the Knowledge-Based Economy. [La política de innovación en la economía d el conocimiento]. Boston: Kluwer Academic Publishers, p. 213-229.

HIMANEN, P, 2001. The Hacker Ethic and the Spirit of the Information Age. [La ética hacker y el espíritu de la era de la información]. Nueva York: Random House.

KAHN, D. 1996. The Codebreakers; The Comprehensive History of Secret Communication from Ancient Times to the Internet. [Los violadores de códigos: Historia exhaustiva de la comunicación secreta desde la antigüedad hasta Internet]. Nueva York.

KATZ, J. 2000. Geeks: How Two Lost Boys Rode the Internet Out of Idaho. [Los geeks: Cómo dos muchachos perdidos salieron de Idaho gracia s a Internet] Nueva York: Broadway Books.

LANGE, L. 1999. “The Internet.” [Internet]. IEEE Spectrum 36 (1), Enero: 35-40. LIEBESKIND, J., A. L. OLIVER, L .G. ZUCKER, AND M. B. BREWER. 1995. “Social Networks, Learning, and Flexibility: Sourcing Scientific Knowledge in New Biotechnology Firms,” [Redes sociales, aprendizaje y flexibilidad: crear el conocimiento científico en las nuevas empresas de biotecnología]. Organizational Science 7 (4): p.428-443.

LITAN, R. E. y A. M. RIVLAN. 2001. “The economy and the Internet: What lies ahead? [La economía e Internet: ¿que hay delante?]. Information Impacts Magazine. Abril. http://www.cisp.org/imp/ april_2001 /04_01litan-rivlan.htm

MARGHERIO et al. 2000. The Emerging Digital Economy. [La economía digital emergente]. Secretariat on Electronic Commerce, Department of Commerce.

EEUU. MARSHALL, A. 1890. Principles of Economics. [Principios de Economía]. Londres: Macmillan.

ORGANIZACIÓN PARA LA COOPERACIÓN Y EL DESARROLLO ECONÓMICOS (OCDE). 2000. OECD Information Techno logy Outlook 2000: ICTs, E-commerce and the Information Economy. [Perspectiva de la OCDE sobre la tecnología de la información para el año 2000: las TIC, el comercio electrónico y la economía de la información]. París:

OCDE. PELLETIERE, D. y G. C. RODRIGO. 2001. “Economic geography and policy in the network age.” [La geografía y la política económica en la era de las redes]. En M. P. Feldman y A. N. Link, editores, Innovation Policy in the Knowledge-Based Economy. [La política de la innovación en la economía del conocimiento]. Boston: Kluwer Academic Publishers, p. 231-257.

ROSEN, J. 2000. The Unwanted Gaze: The Destruction of Privacy in America. [La intromisión no deseada: la destrucción de la intimidad en América]. Nueva York: Random House.

SAHLMAN, W.A. 1990. “The Structure and Governance of Venture-Capital Organizations.” [Estructura y gobierno de las organizaciones de capital de riesgo]. Journal of Financial Economics: 27:473-522.

SAXENIAN, A. 1990. Regional Advantage. [La ventaja regional]. Cambridge, Tesis de Maestría, Harvard University Press SCHNEIER, B. 2000. Secrets and lies: digital security in a networked world . [Secretos y falsedades: la seguridad digital en un mundo de redes]. Nueva York: John Wiley.

SHAPIRO, C. y H. R. VARIAN. 1999 Information Rules: A Strategic Guide to the Network Economy, [Las reglas de la información: guía estratégica para la economía de redes]. Boston: Harvard Business School Press.

STANDAGE, T. 1998. The Victorian Internet. [La Internet Victoriana]. Nueva York: Berke ley Books.

WEITZMAN, M. L. 1998. “Recombinant Growth” [El crecimiento recombinante]. Quarterly Journal of Economics.

ZOOK, M. 2000. “The web of production: the economic geography of commercial Internet content production in the United States.” [La web de producción: geografía económica de la producción del contenido comercial de

Fuente:file:///C:/Users/Administrador/Downloads/feldman.pdf

Fuente imagen: https://encrypted-tbn2.gstatic.com/images?q=tbn:ANd9GcT7IiPrI5DoGi4zm0RYLfkKa-RiUMaO8Y1XvV39oSG3MCQtQJjQMA

Email: maryann.feldman@unc.edu

Users Today : 52

Users Today : 52 Total Users : 35474799

Total Users : 35474799 Views Today : 61

Views Today : 61 Total views : 3574854

Total views : 3574854